Материалы по тегу: sds

|

20.05.2025 [19:00], Владимир Мироненко

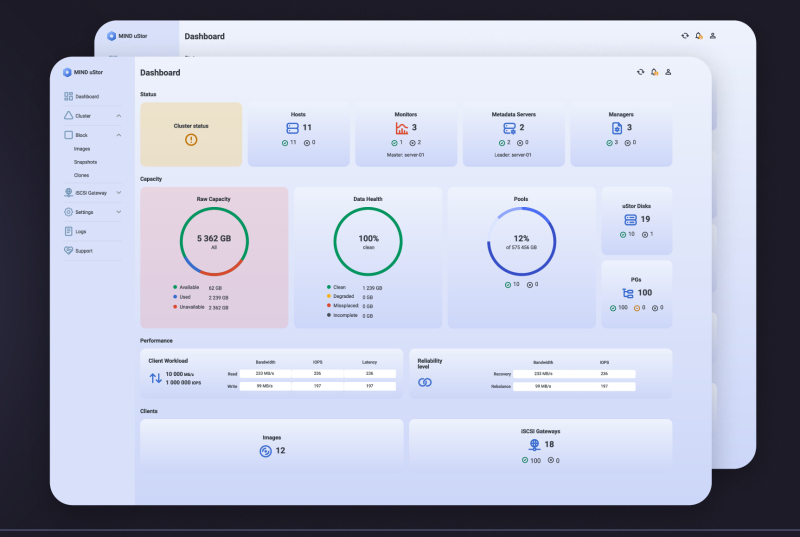

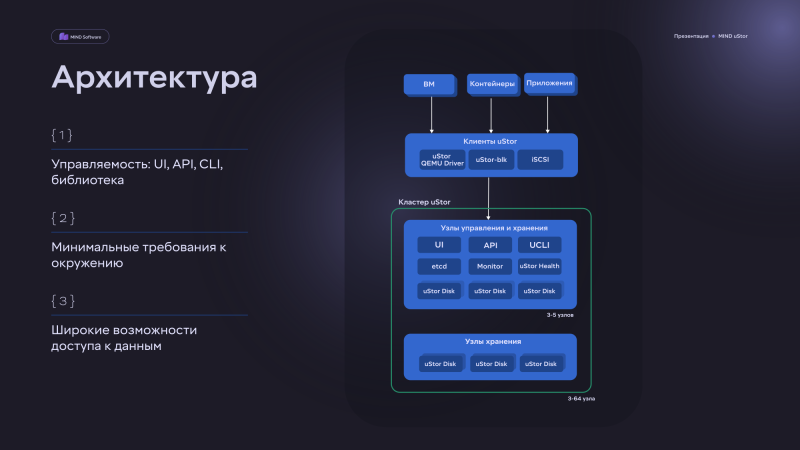

MIND Software анонсировала отечественную программно определяемую СХД MIND uStorMIND Software представила распределённую блочную программно определяемую СХД MIND uStor, предназначенную для корпоративного сегмента отечественного рынка. Ключевая функциональность новинки — сервисы оркестрации, мониторинга, информационной безопасности, графический интерфейс, снапшоты, REST API, CLI, доступ по iSCSI и т.п. — была создана компанией с нуля на основе собственных разработок в соответствии с современными требованиями к высокой надёжности, производительности и технологической независимости продукта, говорит MIND Software MIND uStor позволяет построить отказоустойчивое, масштабируемое и производительное хранилище данных с возможностью интеграции с платформами серверной и контейнерной виртуализации, в том числе в гиперконвергентных (HCI) конфигурациях. Платформа совместима с x86-серверами и поддерживает широкий спектр протоколов взаимодействия с виртуальной инфраструктурой. ПО MIND uStor может лицензироваться как для постоянного использования, так и в форме подписки. Доступны лицензии uStor Enterprise HD/AF и Standard. Компания также предлагает комплекс профессиональных услуг для помощи в проектировании и внедрении. Решение отличается универсальностью, позволяя применять его для организаций, чья инфраструктура включает различные облачные платформы и технологии виртуализации. Оно позволяет повысить эффективность использования систем хранения и оптимизировать совокупную стоимость владения инфраструктурой (TCO). По данным MIND Software, её SDS позволяет снизить TCO на 30–60 % по сравнению с традиционными СХД. По словам компании, MIND uStor — логичный и своевременный ответ на растущий спрос на отечественные инфраструктурные решения, способные заменить зарубежные аналоги без потери в надёжности и гибкости. Решение обладает простой архитектурой и минимальными требованиями к ресурсам, легко настраивается и масштабируется под любые задачи. Компания обеспечивает его поддержку на корпоративном уровне в режиме 24/7. Решение может использоваться для хранения томов виртуальных машин, данных контейнеров, а также для построения гиперконвергентных ландшафтов. СХД обладает поддержкой протоколов взаимодействия как собственной разработки, так и отраслевых, например, iSCSI. Подчёркивается, что решение «отлично работает в смешанных инфраструктурах и может применяться в качестве альтернативы или в дополнение к традиционным СХД». Минимальные требования MIND uStor к оборудованию включают наличие трёх узлов (оптимально от пяти узлов). Каждый узел должен иметь хотя бы 32 Гбайт RAM и два восьмиядерных процессора уровня Intel Xeon Skylake-SP с частотой от 2,8 ГГц. Также необходимо наличие двух портов 10/25/40/100GbE (лучше 25 Гбит/с и более) и накопителей NVMe/SATA/SAS SSD или SATA/SAS/NL-SAS HDD — оптимально 8–16 шт. в одном узле. В случае All-Flash конфигураций доступна поддержка RDMA (RoCEv2). Эффективная ёмкость SDS составляет до 80 % от «сырой», но в 2026 году появятся дедупликация и сжатие. Компания планирует запустить в июне программу сертифицированных конфигураций uStor, в рамках которых будет проводиться тестирование оборудования на совместимость и совместно с вендорами аппаратного обеспечения будут разработаны оптимальные конфигурации. На данный момент MIND Software находится на завершающей стадии интеграции с двумя лидирующими на российском рынке платформами виртуализации, официальный релиз совместных решений запланирован на лето 2025. Также на осень запланированы релизы решений по интеграции с платформами контейнеризации. Кроме того, прорабатывается создание ПАК на основе uStor.

09.05.2025 [14:04], Сергей Карасёв

StorONE и Phison предложат СХД для ИИ-задач, с которой можно будет поговоритьКомпании StorONE и Phison объявили о расширении стратегического сотрудничества с целью создания новой платформы хранения данных для локальных развёртываний. Речь идёт о системе, оптимизированной для различных ИИ-задач, таких как разработка больших языковых моделей (LLM), их обучение и инференс в режиме реального времени. В рамках партнёрства будет осуществлена интеграция технологии Phison aiDAPTIV+ с высокопроизводительной программно-определяемой платформой хранения StorONE. Система aiDAPTIV+ позволяет «расширять» память GPU-ускорителей путём использования системной памяти и SSD. Благодаря этому компании могут закупать меньшее количество GPU, что снижает входные барьеры для локального использования LLM. Совместное решение StorONE и Phison обеспечит возможность развёртывания ИИ СХД на площадках клиентов, что важно для отраслей, где большое значение имеет конфиденциальность информации: здравоохранение, финансы, государственное управление и пр. Благодаря технологии aiDAPTIV+ компании и организации смогут использовать в собственных ЦОД крупные модели ИИ. При этом встроенный чат-бот поможет в управлении и оптимизации конфигурации хранилища: делать запросы и отдавать команды пользователи смогут на естественном языке. Ожидается, что первое интегрированное решение в рамках партнёрства станет доступно во II квартале текущего года. Оно объединит массивы хранения данных с высокой пропускной способностью StorONE и усовершенствованную систему aiDAPTIV+. Ключевыми сферами применения названы локальное обучение LLM, мультимодальный ИИ и генеративные приложения.

12.03.2025 [14:45], Сергей Карасёв

10+ Тбайт/с: Pure Storage представила высокопроизводительную All-Flash СХД FlashBlade//EXA для ИИ и НРСКомпания Pure Storage анонсировала систему FlashBlade//EXA: это, как утверждается, самая производительная на сегодняшний день платформа хранения данных, разработанная специально для наиболее требовательных нагрузок ИИ и HPC. Отмечается, что стандартные СХД оптимизированы для традиционных сред HPC с предсказуемыми операциями. Такие системы разрабатываются с прицелом на масштабирование «чистой производительности». Однако современные нагрузки ИИ являются гораздо более сложными и многомодальными: они предусматривают обработку данных разного типа — текстов, изображений и видео — одновременно на десятках тысяч ускорителей. Из-за этого возникает необходимость в оптимизации обработки метаданных наряду с масштабированием производительности. FlashBlade//EXA, по заявлениям Pure Storage, устраняет узкие места традиционных СХД в плане работы с метаданными. Архитектура новой платформы даёт возможность масштабировать ресурсы для обработки обычных данных и метаданных независимо друг от друга. Эффективная обработка метаданных имеет решающее значение для поддержания высокой производительности, надёжности и эффективности в крупномасштабных средах ИИ. Сегмент метаданных Metadata Core в составе FlashBlade//EXA может объединять от 1 до 10 5U-шасси с десятью blade-узлами в каждом. В каждом узле размещается от одного до четырёх фирменных 37.5-Тбайт модуля DFM. Ещё 2U приходится на пару XFM (External Fabric Modules), которые дают 16 подключений 400GbE. Metadata Core работает с фирменной ОС Purity//FB, общается напрямую с GPU-кластером (NFSv4.1 over TCP) и управляет потоками данных между узлами хранения и кластером (NFSv3 over RDMA). Узлы хранения Data Node обладают неограниченной масштабируемостью. Причём эти узлы могут быть самыми обычными x86-серверами любых вендоров. Каждый такой узел должен содержать 32-ядерный CPU, 192 Гбайт RAM, от 12 до 16 NVMe SSD (PCIe 4.0/5.0) вместимостью до 61,44 Тбайт, а также пару 400GbE NIC. Архитектура платформы предусматривает использование сетевых адаптеров NVIDIA ConnectX, коммутаторов Spectrum, компонентов LinkX и пр. Система FlashBlade//EXA обеспечивает производительность свыше 10 Тбайт/с на операциях чтения в одном пространстве имён. В результате, организации могут значительно ускорить процессы обучения ИИ-моделей и инференса, максимально используя потенциал GPU-ускорителей. Это также способствует снижению временных и финансовых затрат на решение ресурсоёмких задач. По-видимому, именно это решение компания и предлагает гиперскейлерам. У самой Pure Storage есть тестовая конфигурация из 300 узлов, которая показывает производительность на уровне 30 Тбайт/с.

06.03.2025 [13:45], Сергей Карасёв

1,5 Пбайт в 2U и 120 Гбайт/с: PEAK:AIO представила обновлённое All-Flash хранилище AI Data ServerБританский стартап PEAK:AIO анонсировал обновлённую платформу хранения данных AI Data Server, предназначенную для поддержания ресурсоёмких нагрузок ИИ. Сервер в форм-факторе 2U на основе SSD производства Solidigm обеспечивает 1,5 Пбайт «сырой» вместимости. PEAK:AIO утверждает, что благодаря новому программному стеку NVMe устраняются «узкие места Linux», что обеспечивает высокую производительность для приложений ИИ с интенсивным использованием данных. AI Data Server — это программно-определяемое хранилище на стороннем оборудовании. В частности, применяется сервер Dell PowerEdge R7625, оборудованный сетевыми адаптерами NVIDIA ConnectX-7. Заявленная пропускная способность достигает 120 Гбайт/с. Система комплектуется накопителями Solidigm D5-P5336 вместимостью 61,44 Тбайт. Эти изделия выполнены на 192-слойных чипах флеш-памяти QLC 3D NAND и оснащены интерфейсом PCIe 4.0 x4 (NVMe 2.0). Скорость последовательного чтения/записи достигает 7000/3000 Мбайт/с, показатель IOPS при произвольном чтении — 1 005 000. Сервер комплектуется 24 накопителями, что в сумме обеспечивает около 1,5 Пбайт ёмкости. Платформа AI Data Server может использоваться для решения различных задач в специфичных областях, таких как здравоохранение, исследования и периферийные приложения ИИ. Подобные нагрузки требуют наличия высокопроизводительного хранилища, но зачастую доступ к инфраструктуре ЦОД у организаций из указанных отраслей ограничен. Система AI Data Server позволяет устранить данный пробел: она может масштабироваться от единичных узлов до кластеров, рассчитанных на огромные озера данных ИИ.

24.02.2025 [12:05], Сергей Карасёв

DDN представила объектное хранилище Infinia 2.0 для обучения ИИ и инференсаКомпания DataDirect Networks (DDN), специализирующаяся на системах хранения данных для НРС, анонсировала программно-определяемую аппаратно-независимую платформу хранения Infinia 2.0, предназначенную для решения ресурсоёмких задачи в области ИИ, таких как обучение моделей и инференс. Напомним, оригинальная платформа Infinia была представлена в конце 2023 года. Её преимуществами разработчик называет простоту управления, высокую производительность и безопасность. В качестве узлов могут применяться любые серверы с процессорами Intel, Arm или AMD. Решение Infinia 2.0, по заявлениям DDN, специально разработано для анализа огромных массивов данных, подготовки и обработки ИИ-моделей. Утверждается, что платформа устраняет традиционные узкие места, присущие стандартным системам хранения. Поддерживается интеграция с NVIDIA NeMo, NIM, Trino, Apache Spark, TensorFlow и PyTorch. Реализован многопротокольный доступ (объектное, блочное хранилище) для повышения гибкости. DDN отмечает, что Infinia 2.0 обеспечивает пропускную способность в терабайты в секунду и задержку менее 1 мс, превосходя по производительности AWS S3 Express в 10 раз. Достигается 100-кратное ускорение обработки метаданных, а также 25-кратное ускорение запросов для обучения моделей ИИ и инференса. По сравнению с Hadoop новая платформа показывает 10-кратное улучшение быстродействия рабочих нагрузок ИИ при 100-кратном повышении эффективности. Скорость обработки списков объектов выше в 100 раз, чем у AWS. Платформа обладает надёжностью более 99,999 % (время безотказной работы), предлагая сквозное шифрование и доступ на основе сертификатов. Возможно масштабирование от терабайт до эксабайт с поддержкой до более чем 100 тыс. GPU и 1 млн клиентов в одном развёртывании. При этом заявлено 10-кратное снижение требований в отношении питания и охлаждения по сравнению с обычными решениями.

19.11.2023 [00:03], Сергей Карасёв

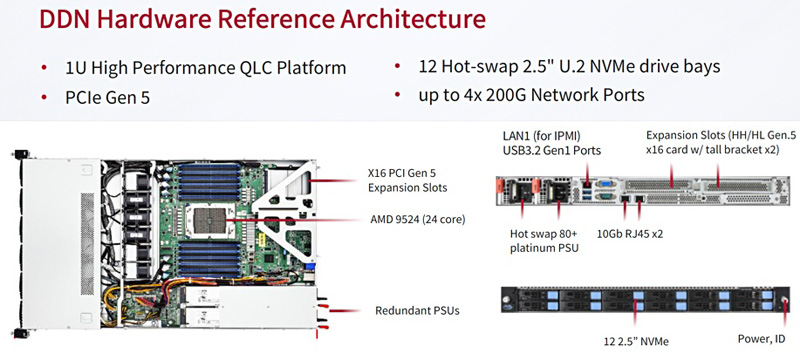

DDN представила масштабируемую All-Flash СХД Infinia для НРС и ИИКомпания DataDirect Networks (DDN), специализирующаяся на платформах хранения данных для НРС-задач, анонсировала масштабируемую СХД Infinia, разработанную в сотрудничестве с Сандийскими национальными лабораториями (SNL) Министерства энергетики США. Infinia — программно-определяемое многопротокольное решение с горизонтальным масштабированием, которое подходит для различных сценариев использования. Это могут быть сложные научные задачи, приложения ИИ, большие языковые модели и пр. Узлами системы могут быть любые серверы с процессорами Intel, Arm или AMD. Говорится, что платформа Infinia может масштабироваться до сотен петабайт. Среди ключевых преимуществ решения разработчик называет простоту управления, высокую производительность и безопасность. Референсная аппаратная платформа представляет собой 1U-узел с 24-ядерным процессором AMD EPYC Genoa. Во фронтальной части предусмотрены отсеки для 12 накопителей SFF формата U.2 (NVMe) с возможностью горячей замены. Предусмотрены два сетевых порта 10GbE и порт 1GbE (все с разъёмами RJ-45), а также слота PCIe 5.0 x16 для HHHL-адаптеров, которые могут предложить до четырёх 200G-портов.

Источник изображения: DDN / StorageNewsletter Шасси имеет габариты 680 × 450 × 44 мм и весит 22,9 кг. СХД оборудована двумя блоками питания мощностью 850 Вт с сертификатом 80 Plus Platinum. В системе воздушного охлаждения применяются шесть вентиляторов. Диапазон рабочих температур — от +10 до +35 °C.

15.11.2023 [22:36], Владимир Мироненко

Hitachi Vantara и Quobyte предложат доступные, надёжные и масштабируемые хранилища для HPCHitachi Vantara, «дочка» Hitachi Ltd., специализирующаяся на СХД, управлении данными и цифровых решениях, объявила на конференции SC23 о партнёрстве с Quobyte, занимающейся разработкой высокопроизводительных программно определяемых хранилищ. Цель альянса — создание долговечных масштабируемых решений для хранения данных с доступной ценой. Партнёрство включает и стратегическое сотрудничество в области маркетинга и взаимодействия с клиентами. Как отмечено в пресс-релизе, интеграция интеллектуальной платформы данных Hitachi Vantara и передовой платформы хранения данных Quobyte «откроет новую эру управления данными, соответствующую меняющимся потребностям современных предприятий и сред HPC». «Объединяя наше мастерство управления данными с возможностями Quobyte в области хранения данных, мы не просто решаем проблемы управления данными, но и поднимаем операционную эффективность на новый уровень», — заявил представитель Hitachi Vantara. Сообщается, что благодаря партнёрству клиентам компаний будут предложены:

15.11.2023 [02:15], Владимир Мироненко

Xinnor xiRAID установил новый рекорд производительности среди NVMe-массивов с PCIe 5.0 SSD от KioxiaВ августе этого года израильская компания Xinnor, специализирующаяся на решениях для хранения данных, в том числе программного RAID для современных NVMe SSD, сообщила в ходе саммита Flash Memory Summit о мировом рекорде производительности, установленном с использованием ПО Xinnor xiRAID и 12-ти NVMe SSD Kioxia CM7-R (PCIe 5.0). На SC23 компания обновила рекорд. На этот раз в тесте были задействованы сразу 24 накопителя Kioxia CM7-V (PCIe 5.0, NVMe). Каждый диск имеет скорость последовательного чтения 14 Гбайт/с и последовательной записи 6,75 Гбайт/с, а на случайных операциях производительность составляет 2,7 млн IOPS и более 600 тыс. IOPS соответственно. При развёртывании множества таких SSD в системе первостепенное значение приобретает обеспечение надлежащей масштабируемости производительности и целостности данных. Xinnor выполнила тест на сервере Supermicro с двумя 64-ядерными процессорами AMD EPYC Genoa 9534 и 768 Гбайт RAM. Чтобы избежать узких мест, Xinnor создала две группы RAID 5 по 12 дисков так, что каждый массив находился в рамках одного NUMA-домена. Такая конфигурация обеспечивает наивысшую производительность и одновременно защиту данных в случае сбоя диска для каждого RAID, говорит Xinnor. Сообщается, что в последовательных рабочих нагрузках рекордные показатели (см. таблицу ниже) были достигнуты при использовании лишь 16 из 128 доступных ядер, а на случайных операциях xiRAID нагружал на 3–9 % лишь половину ядер. Низкая нагрузка на CPU и универсальность xiRAID, по словам компании, значительно упрощает развёртывание массивов и позволяет эффективно использовать имеющееся оборудование. Xinnor также проверила работу в деградированном режиме, когда из массива RAID 5 «выпадает» один накопитель. Даже в этом случае производительность остаётся достаточно высокой: более 34 млн и 6 млн IOPS при произвольных чтении и записи соответственно, что эквивалентно 52 % и 75 % от нормальной производительности. При последовательных операциях доступа Xinnor зафиксировала производительность выше 70 % от нормальной.  Заодно Xinnor также протестировала ту же систему, создав 2 группы RAID 6 (2 × 10 + 2). При чтении производительность была сравнима с RAID 5: 64 млн IOPS и 310 Гбайт/с. При записи производительность была ниже: 5,2 млн IOPS и 128 Гбайт/с. Впрочем, по словам Xinnor, xiRAID быстрее, чем любое другое альтернативное решение RAID.

23.08.2023 [12:47], Сергей Карасёв

Kioxia прекратила развитие платформы хранения данных KumoScaleКомпания Kioxia, по сообщению ресурса Blocks & Files, свернула проект KumoScale по разработке специализированного ПО для хранилищ данных. Выпуск новых версий не планируется, а новые лицензии на данный продукт предоставляться не будут. Поддержка текущих заказчиков сохранится. KumoScale — это программный комплекс, нацеленный на максимизацию использования обычных NVMe-накопителей в дата-центрах. Платформа использует NVMe-oF (RDMA или NVMe/TCP) для формирования быстрых масштабируемых блочных хранилищ с низкой задержкой и позволяет управлять сотнями узлов хранения. Платформа обзавелась поддержкой Kubernetes, OpenStack, NVIDIA Magnum IO GPUDirect Storage (GDS) и т.д. В уведомлении на сайте Kioxia говорится, что развивать платформу KumoScale после версии 3.22 не планируется. Для продукта теперь осуществляется только техническое обслуживание — компания намерена поддерживать существующих клиентов. Какие-либо комментарии по поводу своего решения Kioxia не даёт. Платформа KumoScale начала создаваться в североамериканском подразделении Kioxia (тогда ещё Toshiba) в 2016 году. Со временем она обросла функциональностью, но, как отмечает Blocks & Files, дальнейшее развитие фактически сделало бы её прямым конкурентом продуктов, которые создают заказчики Kioxia.

28.05.2023 [20:18], Владимир Мироненко

Dell расширила возможности APEX, объединив усилия с Microsoft, Red Hat и VMwareDell представила на конференции Dell Technologies World 2023 обновление Dell APEX, которое объединяет службы Microsoft Azure, Red Hat и VMware, и обеспечивает улучшенные управление и мобильность приложений и данных в рамках реализации так называемой стратегии «земля-облако» и «облако-земля». Dell также расширила портфолио услуг и подписок APEX. С точки зрения подхода ground-to-cloud (от земли к облаку) Dell взяла за основу проект Project Alpine и превратила его в совершенно новый каталог продуктов под названием APEX Storage for Public Cloud, перенеся различные службы хранения в публичное облако. Анонсированный новый сервис Dell APEX Cloud Platforms, по словам компании, представляет собой «портфель полностью интегрированных готовых систем, объединяющих инфраструктуру Dell, ПО и облачные операционные стеки, которые обеспечивают согласованные мультиоблачные операции путём переноса облачных моделей работы в локальные и периферийные среды». На практике это означает, что можно управлять данные и рабочими нагрузками в разных облаках и средах и бесшовно перемещать данных между разными платформами. Облачные службы, разработанные в сотрудничестве с Microsoft, Red Hat и VMware, включают:

Компания заявила, что решение Dell APEX Storage for Public Cloud позволит клиентам запускать службы на облачных платформах и безопасно хранить свои данные в инфраструктуре Dell. Также сообщается, что Dell APEX Block Storage for Amazon Web Services (AWS), Dell APEX Block Storage for Microsoft Azure и Dell APEX File Storage for AWS, разработанные в рамках Project Alpine, сочетают в себе производительность, масштабируемость и устойчивость к киберугрозам хранилищ Dell корпоративного класса с экономикой публичного облака. Следует добавить, что эти решения дополняют службу Dell Apex Protection Storage, которая, по словам компании, уже обслуживает 17 Эбайт данных клиентов в облаках. Также сообщается об усовершенствованиях Dell APEX Console, которые упрощают обслуживание мультиоблачных хранилищ и кластеров Kubernetes.

Кроме того, Dell сообщила о появлении ещё двух решений:

На мероприятии было также объявлено о новом многостороннем сотрудничестве Dell и Databricks в рамках которого локальными данными в корпоративных платформах хранения данных Dell можно будет управлять и использовать посредством Databricks Lakehouse. |

|