Материалы по тегу: ocp

|

01.06.2025 [02:06], Сергей Карасёв

Петабайтные E2 SSD готовы со временем потеснить HDD в ЦОДОрганизации Storage Networking Industry Association (SNIA) и Open Compute Project (OCP), по сообщению ресурса StorageReview, разработали новый форм-фактор твердотельных накопителей, получивший обозначение E2. Устройства данного типа будут обладать большой вместимостью, достигающей 1 Пбайт. Для сравнения, Seagate поставила себе цель довести ёмкость HDD до 100 Тбайт к 2030 году, тогда как Pure Storage уже подготовила 150-Тбайт SSD. Стандарт E2 создаётся для «тёплого» хранения данных. Устройства нового формата займут промежуточное положение между HDD большой ёмкости и традиционными корпоративными SSD. Предполагается, что изделия E2 обеспечат оптимальный баланс производительности, плотности и стоимости при развёртывании крупномасштабных озёр данных для приложений ИИ, аналитики и других задач, которым требуются огромные массивы информации. Добиться этого планируется путём использования большого количества чипов QLC NAND в одном накопителе.

Источник изображения: OCP / Micron Физические размеры накопителей E2 составляют 200 мм в длину, 76 мм в высоту и 9,5 мм в толщину. Применяется коннектор EDSFF, который также используется в устройствах E1 и E3. Отмечается, что по высоте SSD и расположению разъёма (27,7 мм от нижней части) формат E2 соответствуют стандарту E3, тогда как размещение светодиодного индикатора идентично E1.

Источник изображения: OCP / Meta✴ Изделия нового типа предназначены прежде всего для установки в серверы с высокой плотностью компоновки. В этом случае система типоразмера 2U сможет нести на борту до 40 устройств E2, что в сумме даст до 40 Пбайт пространства для хранения данных. Новый стандарт предусматривает подключение посредством интерфейса PCIe 6.0 или выше с четырьмя линиями. Заявленная скорость передачи информации может достигать 10 000 Мбайт/с в расчёте на один накопитель. Энергопотребление — до 80 Вт: это означает, что в сервере с 40 такими накопителями только для подсистемы хранения данных потребуется мощность до 3,2 кВт. Таким образом, понадобится эффективное охлаждение — по всей видимости, на основе жидкостных систем. Первая версия спецификации E2 будет готова летом нынешнего года. Значительный вклад в разработку стандарта вносит Micron, которая будет использовать его в своих будущих SSD. Pure Storage и Micron представили прототипы E2 в ходе мероприятия OCP Storage Tech Talk. Проприетарные SSD-модули, отчасти напоминающие E2, уже начали медленно и выборочно вытеснять HDD из дата-центров Meta✴. На подходе и другие гиперскейлеры.

27.05.2025 [11:48], Сергей Карасёв

Сбербанк инициировал банкротство российского производителя OCP-серверов Gagar>nСбербанк, по сообщению ресурса IT Channel News, направил в арбитражный суд заявление о признании ООО «Гагар.ин» банкротом в связи с возникшей задолженностью. Сама компания также намерена обратиться в суд с заявлением о собственной несостоятельности. ООО «Гагар.ин» — юридическое лицо компании Gagar>n, российского разработчика и производителя OCP-оборудования. Продукты компании входят в реестр Минпромторга России. Gagar>n реализует модель полного цикла, включающую самостоятельную разработку механики, схемотехники, электроники и встроенного ПО. Сбербанк требует от ООО «Гагар.ин» 106,04 млн руб. Кроме того, на этапе рассмотрения в адрес поставщика серверов находятся иски от ряда других компаний, в число которых входят: «Мастерпост» (312,43 тыс. руб.), «Треолан» (2,1 млн руб.), «КМС-Эксперт» (25,25 млн руб.), «Системы автоматизированного неинвазивного исследования» (4,37 млн руб.), «Матрикс электроника» (1,43 млн руб.), «Центр программных разработок РТсофт» (1,9 млн руб.), «Плексфорс» (1,32 млн руб.), ТД «Симметрон электронные компоненты» (почти 10 млн руб.), «О-Си-Эс-Центр» (344,25 тыс. руб.) и «Гран Груп» (4,2 млн руб.). Таким образом, общая сумма требований в рамках исков превышает 157 млн руб.

Источник изображения: Gagar>n По итогам 2024 года ООО «Гагар.ин» получило выручку в размере 579 млн руб., что на 56,9 % меньше по сравнению с предыдущим годом. При этом компания показала чистые убытки на уровне 107 млн руб., тогда как в 2023-м была зафиксирована чистая прибыль в 262 млн руб. В 2024 году среднесписочная численность работников ООО «Гагар.ин» составила 112 человек — это на 12 сотрудников меньше, чем в 2023 году. По состоянию на 31 декабря 2024-го совокупные активы организации составляли 1,6 млрд руб., что на 27,1 млн руб. (на 1,7 %) больше, чем годом ранее.

14.05.2025 [14:55], Сергей Карасёв

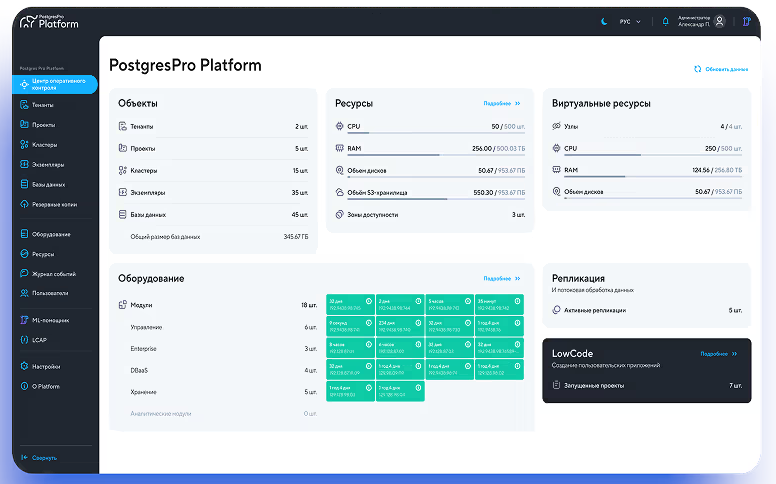

Представлена машина баз данных Postgres Pro Machine для высоконагруженных системКомпания Postgres Professional анонсировала машину баз данных Postgres Pro Machine с модульной архитектурой, предназначенную для высоконагруженных систем. Проект по созданию платформы реализуется в партнёрстве с российским разработчиком и производителем IT-оборудования Delta Computers. В производство машины Postgres Professional инвестирует более 1,5 млрд руб. Утверждается, что Postgres Pro Machine — первая в России платформа, которая может объединять четыре типа разных СУБД. В их число входят высоконагруженные базы данных, обработка аналитических запросов, оркестрация большого количества СУБД среднего размера и горизонтальное масштабирование (шардирование). При этом управлять всеми типами баз данных можно будет через единый графический интерфейс. Конструкция Postgres Pro Machine предусматривает наличие ряда модулей: OLTP, DBaaS, HTAP, OLAP, а также блоков управления, хранения, коммутации и питания. Модуль OLTP, который станет доступен в III квартале текущего года, отвечает за такие функции, как работа с большими высоконагруженными базами, высокоскоростной интерконнект, синхронная реплика с минимальной задержкой.

Источник изображения: Postgres Professional В свою очередь, модуль DBaaS (выйдет в I четверти 2026 года) обеспечит работу с большим количеством баз данных, бесшовное управление средой виртуализации, автоматизацию процессов управления, конфигурирования и масштабирования. Модуль HTAP (появится во II квартале 2026-го) будет включать горизонтальное масштабирование с использованием шардирования, работу с базами данных размером 2 Пбайт и более, строгие гарантии изоляции и согласованности данных на базе технологии Postgres Pro. Задачами модуля OLAP (станет доступен в III четверти 2026 года) названы: высокопроизводительная аналитика для данных (2 Пбайт и более), реализация ETL-задач, партицирование больших исторических данных, ведение полной истории изменений, строгие гарантии изоляции и согласованности данных на базе технологии Postgres Pro. Модуль управления в числе прочего обеспечит мониторинг всех компонентов и отказоустойчивое исполнение. Задачи блока хранения — резервное копирование баз данных, хранение шаблонов виртуальных машин, интеграция со всеми продуктами экосистемы Postgres Pro. Модуль коммутации и питания предоставит выделенную сеть для управления оборудованием, централизованное питание по ОСР-стандарту, коммутацию с интерфейсами 100 Гбит/с и 400 Гбит/с. Стойка с оборудованием имеет стандартную ширину 600 мм и использует трёхфазное питание. Отмечается, что благодаря глубокой синергии аппаратного уровня и программного обеспечения Postgres Pro Machine обеспечит рост быстродействия на 30 % и более по сравнению с существующими решениями. Компоненты системы работают на базе Postgres Pro Enterprise и поддерживают всю функциональность, доступную в соответствующем релизе. Среди возможностей — встроенная отказоустойчивость, пулер и балансировка соединений, резервное копирование и восстановление.  Модули DBaaS, HTAP и OLAP поддерживают горизонтальное масштабирование — при необходимости можно добавлять новые вычислительные узлы. Модуль OLTP горизонтально не масштабируется, но можно задействовать несколько таких блоков параллельно. Postgres Pro Machine использует единую модель авторизации и разграничения доступа на всех уровнях — от управления оборудованием до доступа к виртуальным машинам. Интеграция со службой корпоративного каталога выполняется на этапе пусконаладочных работ. «Сейчас большинство российских компаний вынуждены поддерживать несколько различных технологических стеков для работы с базами данных — СУБД на виртуальных машинах; базы данных, работающие без дополнительного слоя виртуализации; аналитические СУБД; СУБД размером более 150 Тбайт. Postgres Pro Machine закроет все эти возможности в рамках одной системы, что обеспечит существенную экономию времени, денег и человеческих ресурсов заказчика», — отмечает заместитель генерального директора Postgres Professional.

02.05.2025 [13:55], Сергей Карасёв

MSI представила многоузловые OCP-серверы на базе AMD EPYC 9005 TurinКомпания MSI анонсировала многоузловые серверы высокой плотности, выполненные в соответствии со стандартом OCP ORv3 (Open Rack v3). Дебютировали модели Open Compute CD281-S4051-X2 и Core Compute CD270-S4051-X4 на аппаратной платформе AMD EPYC 9005 Turin. Решение Open Compute CD281-S4051-X2, выполненное в форм-факторе 2OU, представляет собой двухузловой сервер для инфраструктур гиперскейлеров. Каждый узел может оснащаться одним процессором EPYC 9005 с показателем TDP до 500 Вт и 12 модулями DDR5. Доступны до 12 посадочных мест для накопителей E3.S с интерфейсом PCIe 5.0 (NVMe). Говорится о поддержке CPU-радиаторов Extended Volume Air Cooling (EVAC) и 48-вольтной архитектуры питания ORv3 (48VDC). В свою очередь, Core Compute CD270-S4051-X4 (S4051D270RAU3-X4) — это четырёхузловой сервер стандарта Data Center Modular Hardware Systems (DC-MHS). Устройство имеет типоразмер 2U. Оно подходит для облачных вычислений, CDN-сетей, ИИ-инференса и машинного обучения, виртуализации сетевых функций, телеком-приложений и пр. Каждый узел новинки рассчитан на один чип EPYC 9005 с TDP до 400 Вт. Есть 12 слотов для модулей DDR5-6000 RDIMM/RIMM-3DS суммарным объёмом до 3 Тбайт, три фронтальных отсека для накопителей U.2 с интерфейсом PCIe 5.0 x4 (NVMe), два внутренних коннектора M.2 2280/22110 для SSD с интерфейсом PCIe 3.0 x2 (NVMe), а также слот PCIe 5.0 x16 OCP 3.0. Кроме того, каждый узел располагает контроллером ASPEED AST2600, сетевым портом управления 1GbE, разъёмами USB 2.0 Type-A и Mini DisplayPort, последовательным портом (USB Type-A). Вся система Core Compute CD270-S4051-X4 оборудована двумя блоками питания мощностью 2700 Вт с сертификатом 80 PLUS Titanium. Установлены четыре вентилятора охлаждения с возможностью горячей замены. Диапазон рабочих температур — от 0 до +35 °C. Габариты составляют 448 × 87 × 747 мм.

02.05.2025 [13:50], Сергей Карасёв

MiTAC анонсировала OCP-серверы на основе AMD EPYC Turin с воздушным и жидкостным охлаждением, а также edge-сервер на базе Intel Xeon Sapphire RapidsКомпания MiTAC Computing Technology представила OCP-серверы нового поколения C2810Z5 и C2820Z5, предназначенные для приложений ИИ и НРС. Устройства выполнены на аппаратной платформе AMD EPYC 9005 Turin. Решение C2810Z5 типоразмера 2OU имеет двухузловую конструкцию. Каждый узел допускает установку одного процессора и 12 модулей оперативной памяти DDR5-6400. Доступны шесть отсеков для накопителей U.2 и два посадочных места для SSD стандарта E1.S. Предусмотрены слоты PCIe 5.0 x16 для карт FHHL, HHHL и OCP NIC 3.0. Устройство оснащено воздушным охлаждением. Данная модель подходит для развёртывания микросервисов в облачных средах. В свою очередь, вариант C2820Z5 — это четырёхузловая система 2OU с технологией прямого жидкостного охлаждения. Каждый узел поддерживает два процессора EPYC 9005 Turin и 24 модуля памяти DDR5. Сервер подходит для высокопроизводительных вычислений. Кроме того, MiTAC анонсировала семейство серверов Whitestone 2 (WS2): это, как утверждается, компактная, но мощная платформа, специально оптимизированная для сетей Open RAN и периферийных задач. Система выполнена в корпусе небольшой глубины формата 1U. Задействован процессор Intel Xeon поколения Sapphire Rapids. Предусмотрены восемь слотов для модулей DDR5. Во фронтальной части находятся четыре порта 25GbE SFP28 и восемь портов 10GbE SFP+. Говорится о поддержке IEEE 1588 v2, Sync-E и GPS для синхронизации. В тыльной части располагаются вентиляторы охлаждения в виде девяти сдвоенных блоков.

01.05.2025 [00:45], Руслан Авдеев

Google готовит мегаваттные стойки с питанием 400 В и СЖО для ИИ-платформ будущегоGoogle представил технологию питания 400 В постоянного тока (DC) и систему жидкостного охлаждения пятого поколения Project Deschutes для стоек нового поколения, которы призваны поддержать стремительное развитие ИИ. В течение последних десяти лет компания использует питание 48 В DC, но переход к новому стандарту позволит повысить максимальную мощность на одну стойку со 100 кВт до 1 МВт. Ожидается, что отдельные стойки с ИИ-системами будут потреблять свыше 500 кВт уже к 2030 году. Так, грядущий суперускоритель NVIDIA Rubin Ultra NVL576, который появится в 2027 году, будет «упакован» в стойку нового поколения Kyber и потреблять порядка 600 кВт. Google, надо полагать, разработает собственную модификацию данного ускорителя, адаптированного к её дата-центрам, как уже сделала для GB200 NVL72. Использование 400 В позволяет задействовать цепочку поставок, используемую индустрией электромобилей, что способствует снижению затрат и повышению качества. Совместно с Meta✴ и Microsoft компания Google работает над проектом Mt. Diablo, в рамках которого вырабатываются общие стандарты электрических и механических интерфейсов. Первая версия спецификаций (v0.5) будет доступна для отраслевого обсуждения в мае 2025 года.

Источник изображения: Google Подсистема питания в Mt. Diablo вынесена в отдельный модуль (sidecar). Это увеличивает полезное пространство в серверных стойках, позволяя целиком отдать их под ускорители, и повышает общую энергоэффективность приблизительно на 3 %, что в масштабах гиперскейлера очень существенно. В перспективе рассматривается переход на прямое распределение высоковольтного постоянного тока внутри ЦОД для ещё большей эффективности и повышения плотности.

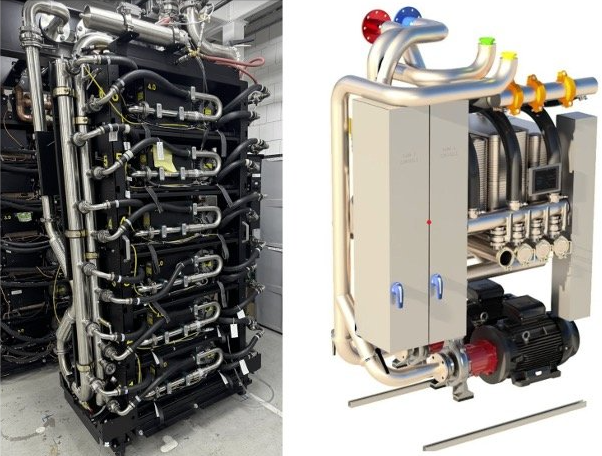

Источник изображения: Google С резким повышением энергопотребления чипов использование СЖО стало неизбежным. В последние семь лет Google развернула СЖО в более 2 тыс. кластеров TPU Pod. Впервые жидкостное охлаждение стало применяться для ИИ-ускорителей TPU v3, появившихся в 2018 году. Компания использует водоблоки, что позволяет практически удвоить плотность размещения вычислительных мощностей в сравнении с воздушным охлаждением. При переходе от TPU v2 к TPU v3 это также позволило вчетверо увеличить размер кластеров. СЖО применяются и для ускорителей Ironwood (TPU v7). CDU-архитектура Project Deschutes, в которой используются резервные теплообменники и насосы, обеспечивает уровень доступности 99,999 %. Пятое поколение Project Deschutes Google планирует передать Open Compute Project (OCP) в 2025 году. Публикация спецификаций, проектных данных и рекомендаций по эксплуатации ускорит массовое внедрение СЖО в индустрии. В компании уверены, что совместные усилия помогут индустрии справиться с будущими вызовами в индустрии ИИ и масштабировать вычислительные мощности и дальше.

18.03.2025 [23:26], Владимир Мироненко

Dell представила сервер PowerEdge XE8712 на базе NVIDIA GB200 NVL4Компания Dell представила сервер PowerEdge XE8712, предназначенный для обработки разнообразных ИИ-нагрузок и HPC, включая обучение ИИ-моделей, молекулярное моделирование, геномное секвенирование, а также моделирование процессов на финансовых рынках.

Источник изображений: Dell В основе PowerEdge XE8712 лежит плата NVIDIA GB200 NVL4. Сервер оснащён суперчипом GB200 Grace Blackwell Superchip, включающим четыре ускорителя B200 Blackwell и два 72-ядерных Arm-процессора NVIDIA Grace. Как отмечает производитель, благодаря возможности установки до 144 ускорителей NVIDIA Blackwell (36 узлов) в одну стойку Dell серии IR7000, XE8712 обеспечивает одну из самых высоких в отрасли плотностей размещения GPU. Это позволяет выполнять больше рабочих нагрузок ИИ и HPC в меньшем физическом пространстве, снижая эксплуатационные расходы без ущерба для вычислительной мощности. Для отвода тепла в XE8712 используется технология прямого жидкостного охлаждения (DLC) — до 264 кВт на стойку. Dell IR7000 отличается раздельными полками питания с общей шиной питания мощностью до 480 кВт. Эта модульная ORv3-стойка легко интегрируется в различное окружения и будет совместима с серверами Dell PowerEdge следующего поколения.

04.03.2025 [11:10], Сергей Карасёв

SoftBank, ZutaCore и Foxconn представили стоечную систему с ИИ-серверами на базе NVIDIA H200 и двухфазной СЖОКомпании ZutaCore, Hon Hai Technology Group (Foxconn) и SoftBank объявили о внедрении двухфазной технологии прямого жидкостного охлаждения (DLC) в ИИ-сервер с ускорителями NVIDIA H200. Утверждается, что это первая подобная реализация на рынке. Двухфазная DLC-система ZutaCore служит для отвода тепла от CPU, GPU, микросхем памяти и других критичных компонентов в серверах. Данное решение по сравнению с традиционными средствами охлаждения позволяет снизить энергопотребление дата-центра и повысить общую эффективность. В результате сокращаются выбросы вредных газов в атмосферу. Система ZutaCore использует специальную охлаждающую пластину, которая находится в контакте с CPU, GPU и другими элементами сервера с большим тепловыделением. Применяется диэлектрическая жидкость с низкой температурой кипения: при нагреве происходит фазовый переход из жидкого в газообразное состояние. Эффективное охлаждение достигается благодаря многократному испарению и конденсации.

Источник изображений: ZutaCore При этом температура жидкости может поддерживаться на более высоком уровне, чем в обычных системах с водяным охлаждением, что повышает эффективность отвода тепла, говорится в пресс-релизе. Кроме того, снижается нагрузка на насос, что способствует сокращению энергопотребления. Использование диэлектрического состава предотвращает серьезные повреждения сервера в случае протечки. В рамках партнёрства Foxconn разработала ИИ-сервер на базе NVIDIA H200 с двухфазной DLC-системой ZutaCore. В свою очередь, SoftBank создала серверную стойку, предназначенную для максимально эффективного охлаждения оборудования посредством двухфазной DLC-технологии. Эта ORv3-стойка совместима с 21″ и 19″ серверами. Источники питания и основная проводка сосредоточены в задней части для обеспечения безопасности эксплуатации и повышения удобства обслуживания.

03.03.2025 [15:23], Руслан Авдеев

Google развернула уже 100 млн литий-ионных ячеек в своих ЦОДСистемы энергоснабжения дата-центров во многом зависят от аккумуляторов в составе ИБП. Участники рынка ЦОД активно инвестируют в создание аккумуляторных систем — не так давно число используемых Li-Ion элементов в дата-центрах Google по всему миру достигло 100 млн шт., сообщает пресс-служба компании. В Google используются системы электропитания с 48 В постоянного тока (48Vdc), причём ИБП интегрированы непосредственно в стойки. Такая распределённая архитектура обладает двумя ключевыми преимуществами: область возможного сбоя ИБП ограничивается одной стойкой; нет дополнительной точки отказа между ИБП и серверами. Такой подход снижает общую стоимость владения (TCO), поскольку ИБП масштабируется вместе с инфраструктурой, благодаря чему уменьшаются затраты на начальном этапе внедрения, говорит компания. Размещение батарей на DC-шине вместе с серверами исключает потери энергии, связанные с промежуточными преобразованиями переменного тока (AC) в постоянный (DC), положительно влияя на общую эффективность системы. В 2016 году Google открыла спецификации своей системы электропитания стоек, включая спецификации для литий-ионных BBU, в рамках Open Compute Project (OCP). Кроме того, Li-Ion аккумуляторы вдвое долговечнее и вдвое мощнее свинцово-кислотных элементов, применявшихся ранее. Таким образом, переход с одних на другие означает, что теперь можно использовать меньше батарей, что также положительно влияет на экологичность ЦОД, говорит Google. В Google отмечают, что развернуть 100 млн Li-Ion элементов можно только благодаря подходу «безопасность прежде всего», принятому в компании. Основным риском для такого типа элементов является возможность неуправляемого нагрева, т. н. «теплового разгона» в случае, если с ними некорректно обращаются, чрезмерно заряжают или не охлаждают должным образом. В результате могут случаться пожары, и хотя такое бывает редко, огонь очень трудно погасить из-за выделения большого количества тепла и риска «цепной реакции» воспламенения соседних элементов. Для использования большого «парка» АКБ в Google применяют метод тестирования UL9540A (стандарт, разработанный для оценки безопасности энергосистем, включая аккумуляторы) и проводит строгие испытания литий-ионных блоков BBU. В результате Google успешно получила от регуляторов разрешения на использование BBU даже в Азиатско-Тихоокеанском регионе, где действуют самые жёсткие правила. Сейчас в Google изучают возможность использования больших энергохранилищ (BESS). Безопасность аккумуляторов — не праздный вопрос. Пожары в дата-центрах вообще случаются не так уж редко, а во многих случаях причиной служат именно инциденты с аккумуляторами. За примерами не надо далеко ходить: один из крупнейших в мире сбоев ЦОД южнокорейской площадки Kakao произошёл именно из-за перегрева и возгорания литий-ионных аккумуляторов SK On, что привело к пожару. В сентябре 2024 года из-за возгорания Li-Ion элементов ИБП пострадал сингапурский ЦОД Digital Realty. В 2023 году эксперты Uptime Institute предупреждали о возможной опасности использования Li-Ion элементов в дата-центрах, поскольку они подвержены повышенному риску возгорания.

04.01.2025 [15:21], Руслан Авдеев

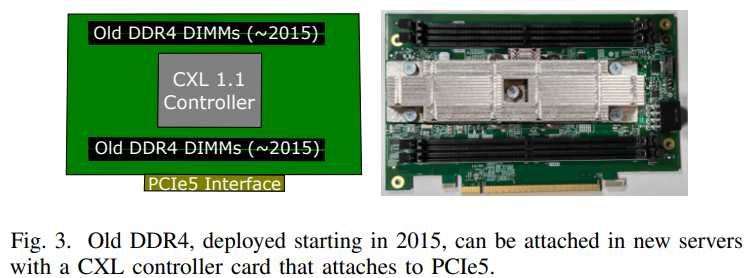

Microsoft совместно с учёными США разработала экологичные облачные серверы GreenSKU, которые используют RAM и SSD из старых системУчёные из Microsoft, Университета Карнеги-Меллона и Вашингтонского университета разработали новый стандарт экологичных серверов GreenSKU, которые позволят снизят углеродные выбросы ЦОД, сообщает IEEE Spectrum. Кроме того, была представлена модель GreenSKU Framework для расчёта целесообразности использования подобных систем в дата-центрах гиперскейлеров и подбора оптимальных конфигураций. Созданные в рамках концепции GreenSKU прототипы серверов были протестированы в ЦОД Azure.

Источник изображений: Microsoft Исследование, вышедшее минувшим летом, изучает возможность использования компонентов из списанных серверов. Это важно, поскольку сегодня во многих случаях при сбое одного компонента из эксплуатации выводится сервер целиком. Кроме того, Microsoft меняет серверы Azure каждые 3–5 лет для оптимизации производительности. И в этом случае работоспособные компоненты всё равно обычно не используются в других серверах. Согласно выкладкам исследователей, уровень сбоев оперативной памяти (AFR) после кратковременного всплеска вскоре после развёртывания остаётся примерно одинаковым на протяжении не менее семи лет. А износ SSD составляет около половины. Впрочем, в данном случае речь идёт об M.2-накопителях. Их надёжность и скорость работы можно повысить простым объединением в RAID-массив. А для их использования в современных платформах с E1.S-корзинами есть готовые пассивные адаптеры, благо стандарт PCIe обладает обратной совместимостью.  С памятью дело обстоит не так просто. Предыдущие поколения серверов использовали DDR4, тогда как актуальные платформы работают только с DDR5. Однако выход есть — в современных CPU появилась поддержка CXL. Точнее, CXL Type 3 (CXL.mem), что позволяет подключать по PCIe пулы DRAM. Они представлены в виде NUMA-узлов без CPU. Такое подключение памяти даёт большую задержку, но современные гипервизоры умеют работать с такими пулами, отправляя в них редко используемые массивы данных.  Старые процессоры переиспользовать не выйдет. Они гораздо менее энергоэффективны и производительны, при этом на CPU приходится основная часть энергопотребления и, соответственно, углеродных выбросов. Исследователи изучили актуальные предложения вендоров и пришли к выводу, что среди доступных на рынке процессоров наилучшим образом для GreenSKU подходят AMD EPYC Bergamo, которые предлагает большое количество ядер и потоков при сравнимом уровне TDP, пусть и при пониженной производительности каждого ядра, а также поддерживают необходимые протоколы CXL. Для распределения нагрузок используется отдельный программный слой, определяющий, какие задачи можно выполнять на серверах GreenSKU, а какие — на стандартных серверах Azure в зависимости от требований к производительности. Как отмечают исследователи, три четверти развёрнутых в Azure инстансов в среднем используют лишь 25 % выделенных ресурсов CPU и около 15 % от доступной пропускной способности памяти. Точно так же далеко не в полной мере используются и SSD. Вместе с тем есть клиенты, которые выживают максимум из каждого инстанcа. Снижение углеродных выбросов имеет большое значение для облачных вычислений, поскольку они могут составить 20 % всех выбросов к 2030 году — об этом свидетельствуют данные НКО Ассоциация вычислительной техники. В пересчёте на ядро выбросы серверов GreenSKU на 28 % ниже, чем выбросы обычных серверов Azure. А на уровне ЦОД с учётом всех накладных расходов снижение выбросов составляет 8 %. |

|